Время индексации сайта в ПС, ускорение индексации и управление индексацией

В этой статье хочу ответить на вопрос, который не дает покоя многим начинающим веб-мастерам. Когда веб-мастер выкладывает свое творение в интернет, обычно первым делом он добавляет его в поисковые системы, или же закупает на него несколько ссылок, чтобы его сайт сам проиндексировался поисковиками. И с этого момента его начинает донимать вопрос: когда же поисковик проиндексирует его сайт, ведь именно от этого зависит, когда на его сайт придут первые посетители. Возможен и другой вариант, веб-мастер ждет индексации, чтобы добавить сайт в биржу ссылок и получать свои денежки.

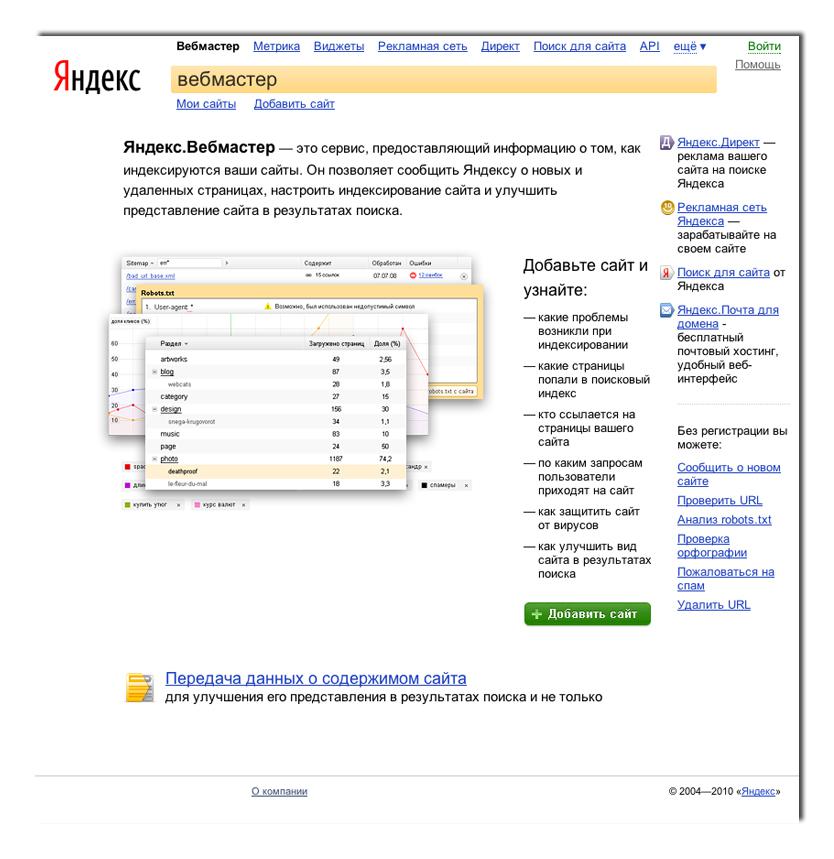

Точно ответить на этот вопрос не может никто, даже сама администрация поисковых систем. Дело в том, что добавлением сайтов и новых страниц в базу ПС занимаются поисковые роботы – это программа, которая переходит по всем ссылкам в интернете от страницы к странице, от сайта к сайту. Соответственно, если на ваш сайт не стоит не одной ссылки, то поисковый робот вообще никогда на него не попадет, это в теории, а на практике бывает иначе, есть мнение, что некоторые поисковые системы отслеживают все новые зарегистрированные домены и именно так находят сайты на которые не стоят ссылки. Но это не факт, если даже это и работает, то таким способом сайт может добавиться в ПС не через один месяц, если добавится вообще. Так что, грамотные веб-мастера добавляют свой сайт в Яндекс.вебмастер и закупают несколько ссылок на других сайтах, или проставляют их на различных форумах, в комментариях и т.д. Если сделать эти не сложные действия новый сайт обычно появляется в базе ПС через 2-3 недели. В Google обычно сайт появляется быстрее чем в Yandex, на Rambler он попадает обычно позже всех. Это конечно не правило, но обычно это происходит в такой последовательности, так как Google всегда быстро добавляет в индекс не только новый сайт, но и новые страницы, а к примеру, Rambler делает это достаточно лениво.

Так же считается хорошим тоном добавлять новый сайт в различные каталоги и социальные закладки, но по моему мнению эта техника давно устарела и сейчас она совсем ни к чему. Так как закладки либо не индексируются вовсе, либо очень и очень медленно. Каталоги сейчас в своем большинстве представляют ссылочную свалку, и пользы с них соответственно мало, либо нет вовсе.

Бытует мнение, что поисковые системы по разному относятся к самому домену. Многие утверждают, что .RU индексируется гораздо лучше чем к примеру .COM или другие. Возможно такая тенденция и наблюдалась, но это было давно и не правда, так как из своего опыта я могу сказать, что разницы в скорости индексации между доменами в зоне .ru и зоне .com нет. Тоже самое касается и уровня домена. Если и замечаются какие либо различия в скорости индексации, то это просто совпадения, либо разные условия (на один домен больше ссылок, а на другой домен меньше, или на один домен проставлены качественные ссылки, а на другой нет). Вот и весь ответ по индексации сайтов поисковыми системами.

Ускоряем индексацию сайта

Некоторым сайтам попасть в индекс поисковых систем не составляет труда, другие же с трудом поддаются индексации, только после появления хороших внешних ссылок на них.

Опробовав различные методы, мне больше понравился такой малозатратный метод ускорения индексации как регистрации нового сайта в социальных закладках. Иногда приходиться прибегать и к покупке постового в каком-нибудь блоге с хорошими показателями индексации и тиц. Давно замечено, что проблемы с индексацией сайта возникают тогда, когда сайт располагает большим числом страниц, которые появляются не постепенно, то есть после каждого обновления, а сразу при добавлении сайта в адурилку. Такая ситуации возникает, когда при посещении вашего сайта поисковый робот находит на нем огромное количество символов сгенерированного контента, к тому же неграмотная перелинковка также усугубляет ситуацию. Одностраничным сайтам или сайтам-визиткам обычно не составляет труда проиндексироваться, но только при наличии на них уникального контента. Вышесказанное дает нам право сделать вывод, что постепенное каждодневное обновление сайта позволит ему быстрее индексироваться, а поисковому роботу изменить расписание обхода сайта, тем самым продвигая его в поиске. Новые страницы сайта попадают в индекс практически моментально, особенно, если дополнить уникальный контент действенным способом ускорения индексации.

Представляю вам мой алгоритм быстрого зачисления сайтов в индекс поисковиков:

1. Выделяем разделы, которые часто обновляются.

К числу таких разделов относятся новости, статьи, отзывы, которые постоянно пополняются и обновляются.

2. Устанавливаем RSS.

Для приведенных выше разделов устанавливает RSS-канал. Основная задача RSS-ленты заключается в помощи поисковикам в установлении точной даты публикаций материалов и анализе вашей активности на сайте.

3. Регистрируемся в сервисе FeedBurner.

FeedBurner предназначен для стандартизации вашего канала с различными юзер-агентами. Также с помощью этого сервиса можно делать рассылку запросов к поисковикам, информируя их о появлении на сайте нового материала.

4. Регистрируемся в Twitter

Если вы еще не имеете аккаунта в Твиттере, то обязательно зарегистрируйте его прямо сейчас. Эта социальная сеть располагает множеством возможностей в плане маркетинга и ускорения индексации сайта.

5. Настраиваем RSS в системе Twitter

Следующим шагом является настройка Твиттерфида в Твиттер. После этой процедуры все записи RSS будут появляются и в вашем твиттер-аккаунте и подписчики будут всегда в курсе обновлений на вашем ресурсе. Таким образом, публикуя новые материалы на сайте, они сначала появляются в RSS-канале, а затем в системе feedburner с пингом крупных сервисов и далее в системе Twitter. Поисковики при условии уникальности добавляемого контента обязательно добавят новые страницы сайта в индекс.

6. Карта сайта.

Создаем карту сайта с помощью плагинов и добавляем карту в панель вебмастера Яндекса и Google.

Как управлять индексацией?

Чаще всего, есть смысл закрыть от индексации некоторые страницы. Например, если на сайте есть форум, то страницы с профилями пользователей, списками участников, поиска или версии страниц для печати лучше закрыть от индексации поисковыми роботами. Данные страницы не несут в себе никакой полезной информации.

Не желательно засорять поисковый индекс ненужной информацией. Чем больше закрыть от поискового робота не нужный и не полезных страниц, тем больше времени он будет уделять открытым для индексирования страницам.

Для того чтобы запретить индексацию определенных страниц вашего сайта, используют специальные инструкции для поисковых роботов, которые размещают в текстовом файле robots.txt, или в мета-теге <META NAME=”ROBOTS”>.

В наше время чаще используют первый вариант. О нем подробней.

Файл robots.txt создается для хранения инструкций по индексированию сайта поисковыми роботами. Его обычно размещают в корне сайта. В robots.txt указывают, в каких папках поисковому роботу можно индексировать, а в каких нет. В данном файле можно создавать инструкции свои для каждого поискового робота, например:

User-agent: StackRambler

Disallow: /price/

Эта запись означает, что поисковому роботу Rambler запрещено индексировать страницы, размещенные в папке “price”. Так, как мы указали именно поискового робота Rambler, то другие поисковые роботы свободно могут индексировать содержимое этой папки.

С помощью файла robots.txt можно запретить индексировать не только одну страницу, но и целые группы страниц.

Источник: forbigblog.ru

- AdSense

- CMS

- CSS

- DLE

- Google Adwords

- HTML

- JavaScript

- Joomla CMS

- MySQL

- PHP

- PR

- SAPE

- SEO

- Web-дизайн

- XML

- Анализ

- Биржи ссылок

- Внешняя оптимизация

- Внутренняя оптимизация

- Графика

- Домены

- Заработок в интернете

- Защита сайта

- Индексация сайтов

- Интернет-маркетинг

- Ключевые слова

- Контекстная реклама

- Контент

- Методы продвижения

- Новости

- Обмен ссылками

- Основы продвижения

- Ошибки web-дизайна

- Поисковые системы

- Полезные сервисы

- Портфолио

- Семантическое ядро

- Советы по продвижению

- Создание сайтов

- Социальные сети

- ТИЦ

- Траст

- Трафик

- Файлообменники

- Хостинг

- Яндекс

info@vismech.ru